atk:解决quantumatk运行性能和内存消耗问题

这是本文档旧的修订版!

解决QuantumATK运行性能和内存消耗问题

在本教程中,您将学习用于提高各种系统 ATK 性能而需要调整的主要参数。为了获得尽可能高的计算性能,ATK 提供了一系列不同的算法,并利用 MPI 和共享内存线程进行并行。正如技术说明 Parallelization of QuantumATK calculations 中已经提到的,MPI 并行通常会提供最佳的计算加速,而进程的线程化通常可以减少内存占用。

要获得任何高性能软件的绝对最佳性能,需要对所涉及的计算和使用的硬件有一定的深入了解。因此,对于使用的硬件和并行方法,优化您的 QuantumATK 模拟非常重要。然而,下面章节给出了一些关于 QuantumATK 算法和选项的提示,也可能有助于解决内存或速度问题。

内存不足?

一般情况

- 尝试禁用 AlgorithmParameters 中的 store_grids,这将稍稍降低内存,轻微减少计算时间。

- 在 AlgorithmParameters 中禁用 store_basis_on_grid 将显著减少内存,如果系统的矩阵很小,则会对性能产生负面影响。默认情况下此参数处于关闭状态,如果构型很大,它可能已被禁用。如果是 并行 运行,由于内存是分布式的,每个核的内存减少量将更低。

- 如果在 并行 有两个以上进程运行,请尝试将 IterationControlParameters 中的 algorithm 设置为 ParallelPulayMixer.d。

特定于分子和块体构型

- 如果矩阵非常大,可以考虑将 AlgorithmParameters 中的 density_matrix_method 设置为 DiagonalizationSolver(processes_per_kpoint=2)。这将使每个 mpi 进程的内存使用减少 2 倍。如果问题持续存在,请尝试增大 processes_per_kpoint。

- 如果计算量非常大,且计算是在 并行 中的许多节点上运行,那么将 AlgorithmParameters 的 density_matrix_method 设置为 ChebyshevExpansionSolver 是很值得尝试的做法。当大规模并行运行时,内存使用将显著减少,但与普通情况相比还是很慢。

特定于器件构型

- 尝试将 SelfEnergyCalculator 中的 storage_strategy 设置为 StoreOnDisk 或 NoStorage。这将显着减少内存,但也会降低之后的性能。如果是 并行 运行,由于内存是分布式的,每个核的内存减少量将更低。

- 器件的横截面较宽,可以尝试将 equilibrium_method 和/或 non_equilibrium_method 设置为 SparseGreensFunction。

- 如果是 并行 运行,将 equilibrium_method 和/或non_equilibrium_method 设置为 SparseGreensFunction(processes_per_contour_point=2) 会有所帮助。如果问题仍然存在,试着设置 processes_per_contour_point=4。

想要运行更快?

一般情况

- 如果计算需要使用多重网格方法,如存在栅的情况,可能对于 possion_solver 要考虑 DirectSolver。这样将需要更多的内存,但是开销是内存分配的,因此如果是 并行 运行,则值得尝试。

- 设置 AlgorithmParameters 中的 store_basis_on_grid 为 True。这将使计算运行更快,并具有适度但分布式的内存开销。

特定于分子和块体构型

在 ATK 2015 中为 AlgorithmParameters 中的 density_matrix_method 引入了两个新增参数:processes_per_kpoint 和 bands_above_fermi_level。

1 algorithm_parameters = AlgorithmParameters( 2 density_matrix_method=DiagonalizationSolver( 3 bands_above_fermi_level=20, 4 processes_per_kpoint=2 5 ), 6 )

- 关于 processes_per_kpoint,您可以指定每个 k 点要使用的 mpi 进程数,从而使您获得更高级别的并行。

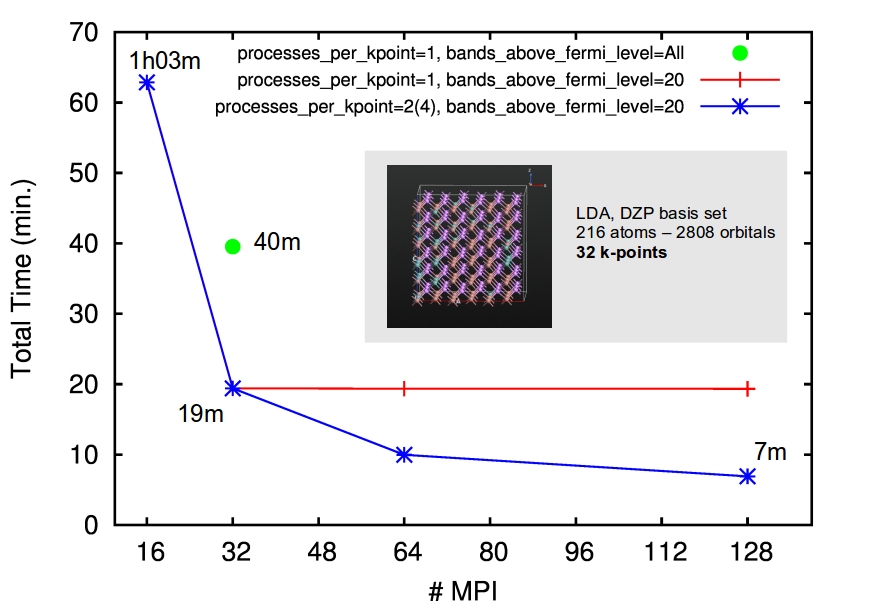

下图展示了使用 32 个 k 点进行 InGaAs 块体构型完整 SCF 运行时间的关系图。默认情况下,您最多可以并行超过 32 个 mpi 进程(红线)。您可以运行以下脚本来快速检查计算中使用了多少个 k 点:

1 mk = MonkhorstPackGrid(4,4,4) 2 irriducible_kpoints = mk.kpoints() 3 print(len(irreducible_kpoints), ' irreducible kpoints')

通过设置 processes_per_kpoint,您现在可以进一步推动并行(蓝线)。

图:在 Xeon E5-2687W @ 3.1GHz 16固化/节点集群上运行的 InGaAs 合金的 199 基准图。时序对应于完整的 SCF 周期(19 步内收敛)。

- 计算中使用的能带总数由基组大小定义。默认情况下,包含所有的空带。但是,在计算中涵盖所有的空带并不能提高准确性,却会大大降低您的模拟速度。设置 bands_above_fermi_level 以指定要使用的空带数量。在上面的示例中,您可以看到使用所有空带(绿点)将使计算时间加倍。

注意

- 空带的最佳使用数量取决于几个因素,包括 LCAO 计算器中指定的电子温度。

- 性能改进随系统的大小增强。对于 < 100 个原子的小型系统,您可以保持默认参数。

特定于器件构型

实际上,您可以调整许多参数获得器件构型的最佳性能。哪些参数需要调整呢?这其实上取决于您正在研究的系统和所使用的方法。

参考

atk/解决quantumatk运行性能和内存消耗问题.1582968505.txt.gz · 最后更改: 2020/02/29 17:28 由 xie.congwei